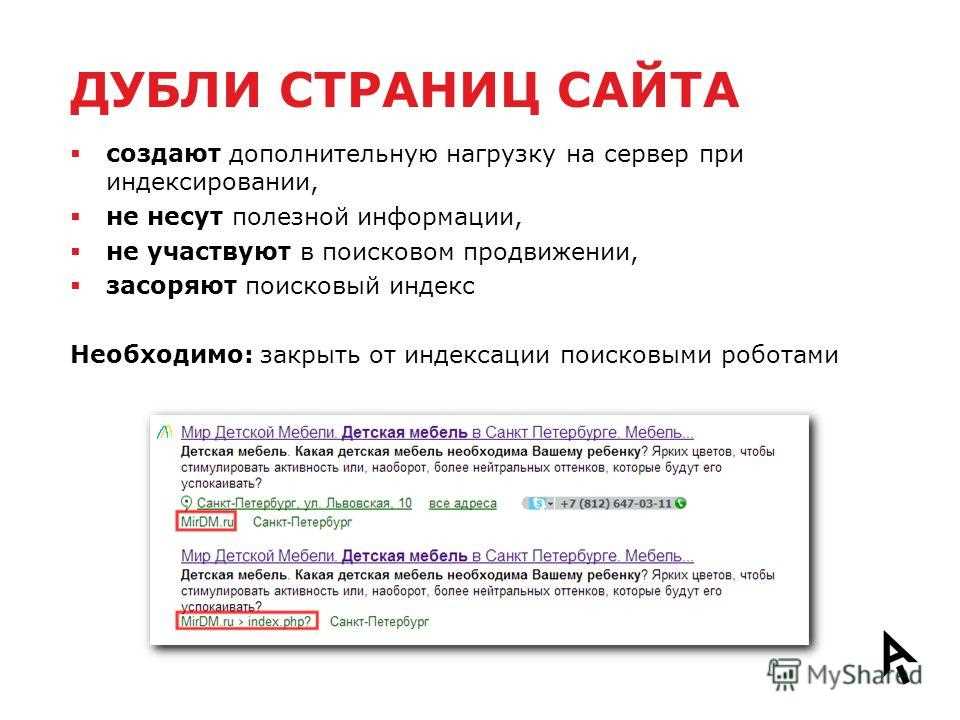

Когда на вашем сайте появляется много лишних страниц, которые не нужно индексировать в поисковых системах, возникает необходимость настроить правильную индексацию. Это позволяет сфокусировать поисковый трафик на нужной информации и не тратить бюджет на рекламу ненужного контента. В данной статье мы расскажем о трех основных способах, которые помогут вам закрыть страницы сайта от индексации.

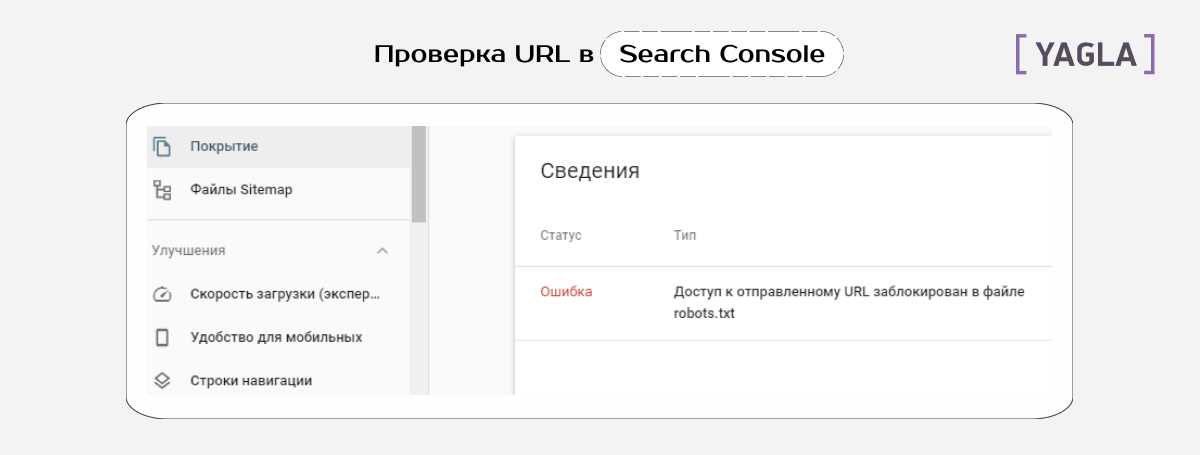

Первый способ заключается в использовании файла robots.txt. Это текстовый файл, который размещается на сервере и содержит инструкции для поисковых роботов. Если на вашем сайте есть страницы, которые не должны быть проиндексированы, вы можете указать их в файле robots.txt с помощью специальных директив. Например, для запрета индексации страницы «example.html» необходимо добавить следующую запись: «Disallow: /example.html». Таким образом, поисковый робот, обращаясь к файлу robots.txt, поймет, что данная страница не должна быть проиндексирована.

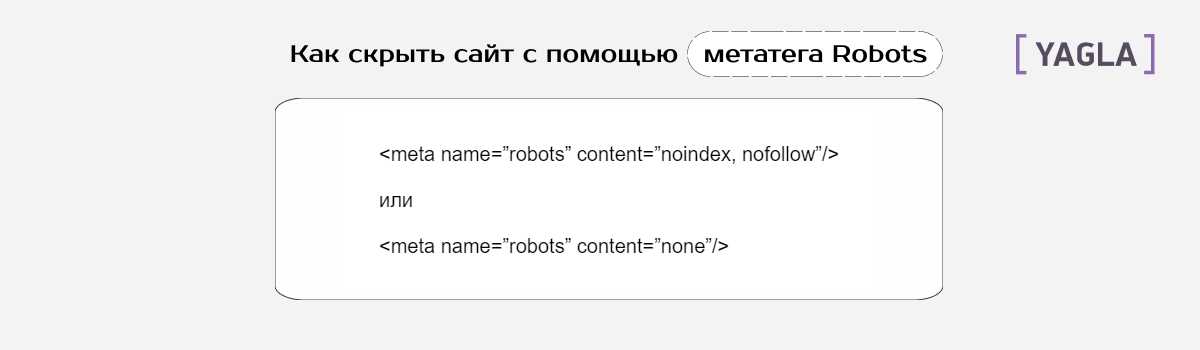

Второй способ заключается в использовании мета-тега «noindex» на отдельной странице. Этот тег указывает поисковым системам, что данная страница не должна быть проиндексирована. Для добавления мета-тега «noindex» на страницу необходимо вставить следующий код в раздел <head> контента страницы: <meta name=»robots» content=»noindex»>. После этого поисковые системы, обращаясь к данной странице, поймут, что ее не следует индексировать.

Третий способ заключается в использовании файла .htaccess на сервере. В этом случае вы можете указать запрет на индексацию для определенных типов файлов или директорий. Например, если у вас есть дублирующий контент на двух разных доменах, вы можете указать следующую запись в файле .htaccess: «Redirect 301 /duplicate.html http://www.example.com/». Таким образом, при обращении к странице «duplicate.html» пользователь будет автоматически перенаправлен на страницу «http://www.example.com/».

Эффективные методы закрытия лишних страниц для индексации

Для того чтобы избежать индексации ненужных страниц сайта и снизить риск дублирования контента, следует использовать эффективные методы закрытия страниц от индексации поисковыми роботами.

В этом случае одним из наиболее эффективных способов является использование мета-тега «noindex». Этот тег помещается в раздел <head> страницы и указывает поисковым роботам, что данная страница не должна индексироваться и отображаться в результатах поиска.

Для того чтобы правильно использовать мета-тег «noindex», вам следует вставить следующий код в раздел <head>:

<meta name=»robots» content=»noindex»>

Также можно использовать файл robots.txt для запрета индексации страницы. Для этого вам следует создать файл robots.txt в корневой директории вашего сайта и добавить следующую запись:

User-agent: *

Disallow: /путь/к/странице/

В данном случае «/путь/к/странице/» следует заменить на реальный путь к странице, которую вы хотите запретить индексировать.

Еще один способ — использование атрибута nofollow. Этот атрибут указывает поисковым роботам, что ссылки на данной странице не должны учитываться при расчете рейтинга сайта. Для того чтобы использовать атрибут nofollow, вам следует добавить его к тегу <a>:

<a href=»ссылка» rel=»nofollow»>текст ссылки</a>

Таким образом, с помощью этих способов вы сможете эффективно закрыть ненужные страницы от индексации поисковыми роботами. Это поможет снизить дублирование контента, улучшить показатели ресурса, сэкономить бюджет на продвижение и увеличить трафик на основных страницах сайта.

Способы избежания индексации ненужных страниц

Для избежания индексации ненужных страниц на сайте существует несколько проверенных способов. В этой статье мы рассмотрим их кратко.

Первый способ — использование мета-тега robots. Этот тег позволяет указать поисковым роботам, какие страницы необходимо индексировать, а какие — нет. Например, если мы хотим запретить индексацию определенной страницы, мы можем добавить следующий код в ее head-секцию:

<meta name="robots" content="noindex">

Второй способ — оформление файла robots.txt. Этот файл находится на сервере и содержит правила для работы робот-индексатора. Например, чтобы запретить индексацию определенной страницы, мы можем добавить следующую строку в файл:

Disallow: /страница

Третий способ — использование атрибута nofollow. Этот атрибут добавляется к ссылкам на странице и указывает роботу, что следующая страница не должна индексироваться. Например, если у нас есть ссылка на страницу «Вход в систему», мы можем добавить атрибут nofollow следующим образом:

<a href="loginвход.html" rel="nofollow">Вход в систему</a>

Важно отметить, что ни один из этих способов не является абсолютно надежным. Некоторые поисковые системы могут все равно проиндексировать страницу, несмотря на ее запрет. Поэтому рекомендуется использовать несколько способов одновременно для максимальной защиты от индексации ненужных страниц.

Также стоит учесть, что дублирование контента на разных страницах может привести к индексации ненужных страниц. Поэтому рекомендуется создавать уникальный контент для каждой страницы и следить за тем, чтобы страницы с одинаковым контентом были закрыты от индексации.

Использование мета-тега robots

В формате HTML мета-тег robots добавляется в секцию head каждой страницы. Он содержит информацию о правилах индексации и сканирования контента страницы.

Для использования мета-тега robots вам необходимо понять, какие страницы вашего сайта должны быть индексированы, а какие — нет. В случае, если вся информация на вашем сайте должна быть доступна для поисковиков, то вам не нужно ничего менять в коде. Однако, в большинстве случаев сайты имеют страницы, которые не предназначены для поискового индексирования.

Чтобы указать запрет индексации для отдельной страницы, вам следует использовать мета-тег robots с атрибутом «noindex». Например:

| Пример использования мета-тега robots |

|---|

| <meta name=»robots» content=»noindex»> |

Этот код следует добавить в секцию head страницы, которую вы хотите исключить из индексации поисковыми системами. После добавления этого кода поисковые роботы, обрабатывая страницу, поймут, что они не должны индексировать ее и не будут включать ее в выдачу поиска.

Однако, важно понимать, что мета-тег robots является всего лишь рекомендацией для поисковых систем и не гарантирует полного запрета индексации страницы. Некоторые поисковые системы могут проигнорировать этот тег, поэтому его применение не всегда является гарантией от индексации.

Также стоит отметить, что мета-тег robots не влияет на трафик, который будет генерироваться на вашем сайте. Если страница не будет индексироваться поисковыми системами, она все равно может быть доступна пользователям через ссылки на других страницах сайта или из внешних источников.

Поэтому, при использовании мета-тега robots, следует учитывать все возможные случаи и проверить его действие. Для этого можно воспользоваться инструментами, такими как Yoast SEO, которые позволяют проверить индексацию страницы и наличие запрета на индексацию.

Использование мета-тега robots — один из способов контроля индексации страниц вашего сайта. Он позволяет указывать поисковым системам, какие страницы следует индексировать, а какие — нет. Однако, его применение не всегда гарантирует полный запрет индексации, поэтому важно внимательно следить за настройками и проверять результаты.

Оформление файла robots.txt

Для начала, вам понадобится создать файл robots.txt и разместить его на вашем сервере. Чтобы это сделать, вы можете воспользоваться FTP-клиентом, например, FileZilla, или другими доступными средствами.

После создания файла, откройте его в текстовом редакторе и вставьте следующий код:

User-agent: Googlebot

Disallow: /здесь-указывается-путь-к-странице-которую-нужно-закрыть/

Вместо «/здесь-указывается-путь-к-странице-которую-нужно-закрыть/» следует указать путь к конкретной странице, которую вы хотите исключить из индексации. Например, если вы хотите запретить индексацию страницы «example.com/nepage», то вместо «/здесь-указывается-путь-к-странице-которую-нужно-закрыть/» следует написать «/nepage».

Таким образом, вы можете указать несколько запретов для разных страниц или директорий. Для каждого запрета следует использовать новую строку.

После внесения необходимых изменений, сохраните файл и загрузите его на ваш сервер. Обратите внимание, что файл robots.txt должен быть доступен по адресу «http://example.com/robots.txt», где «example.com» – ваш домен.

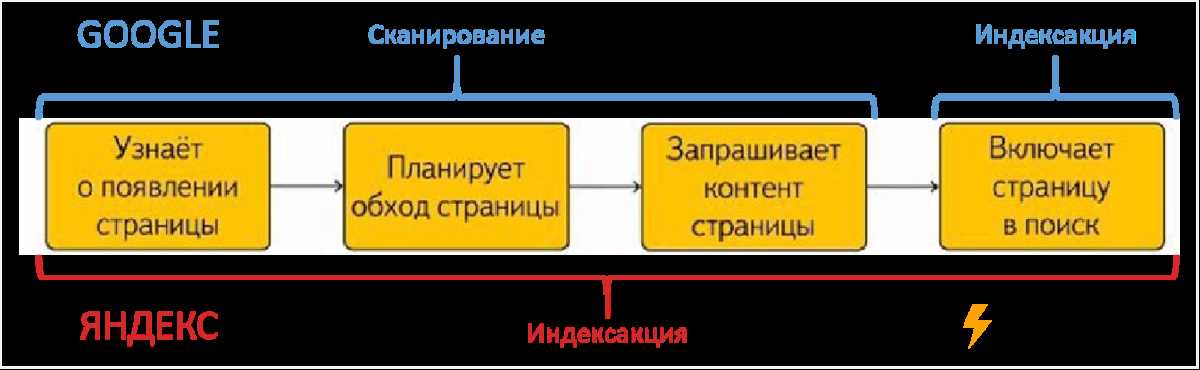

После этого Googlebot и другие поисковые роботы будут проверять файл robots.txt при каждой индексации вашего сайта, чтобы узнать, какие страницы следует индексировать, а какие – нет.

Зависимости от вашей стратегии, вы можете настроить индексацию отдельной страницы или всего раздела вашего сайта. Например, если вы хотите запретить индексацию всего раздела «example.com/blog/», то в файле robots.txt следует указать:

User-agent: *

Disallow: /blog/

Эта инструкция запретит индексацию всех страниц, которые находятся в директории «example.com/blog/».

Важно помнить, что файл robots.txt не является средством гарантированного запрета индексации. Некоторые роботы-индексаторы могут его проигнорировать или просто не прочитать. Однако, большинство поисковых систем всегда проверяют файл robots.txt перед индексацией сайта.

Также следует учесть, что файл robots.txt не ограничивает доступ к вашим страницам для пользователей или трафику с других источников. Он лишь предоставляет инструкции поисковым роботам.

Для более точной настройки индексации вашего сайта рекомендуется использовать дополнительные инструменты, такие как плагин Yoast SEO для WordPress или инструменты Google Search Console.

Применение атрибута nofollow

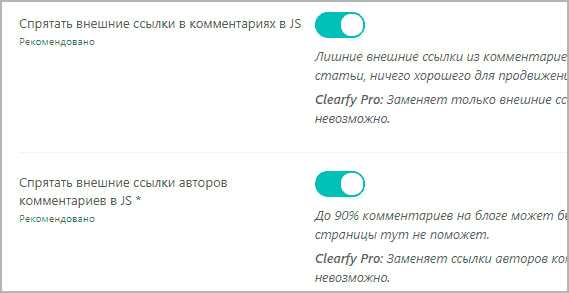

Атрибут nofollow добавляется к коду ссылки, чтобы указать поисковым роботам (например, Googlebot или Яндекс.Бот), что они не должны следовать по ссылке и индексировать содержимое страницы, на которую она ведет.

Применение атрибута nofollow особенно полезно, когда на вашем сайте есть ссылки на внешние ресурсы, такие как социальные сети или другие сайты, и вы не хотите, чтобы поисковые роботы индексировали эти страницы. Таким образом, вы сохраняете контроль над тем, какие страницы вашего сайта будут индексированы поисковиками.

Для применения атрибута nofollow достаточно добавить его к коду ссылки. Например, если у вас есть ссылка на страницу входа в магазине:

<a href="https://www.shopinfo.com/login">Вход в магазин</a>

Применение атрибута nofollow в данном случае будет выглядеть следующим образом:

<a href="https://www.shopinfo.com/login" rel="nofollow">Вход в магазин</a>

Таким образом, поисковые роботы, следующие по ссылке «Вход в магазин», не будут индексировать содержимое страницы входа в магазине.

Применение атрибута nofollow очень важно для правильной настройки запрета индексации страницы. В зависимости от созданного вами контента и круга поисковых систем, с которыми вы работаете, вы можете использовать этот способ для ограничения индексации определенных страниц вашего сайта.

Детализированная инструкция по настройке запрета индексации страницы

Прежде всего, проверьте, установлен ли файл robots.txt на вашем ресурсе. Если его нет, создайте отдельный файл с названием «robots.txt» и разместите его в корневой директории вашего сайта.

Откройте файл robots.txt с помощью любого текстового редактора, например, Notepad или FileZilla. Вставьте следующий код в файл:

User-agent: *

Disallow: /страница

Замените «/страница» на адрес страницы вашего сайта, которую вы хотите запретить для индексации. Если у вас есть несколько страниц, которые нужно запретить, каждую страницу следует указывать в отдельной строке.

Учтите, что запрет индексации поисковыми роботами не гарантирует полной невидимости страницы в поиске. Некоторые поисковые системы, такие как Яндекс, могут проигнорировать указания из файла robots.txt и все равно проиндексировать страницу.

Для более надежной стратегии запрета индексации страницы рекомендуется использовать мета-теги «noindex» и «nofollow» в контенте страницы. При этом в файле robots.txt можно указать только запрет на индексацию, а все остальные указания по контролю индексации следует делать на самой странице.

Несмотря на это, настройка запрета индексации страницы в файле robots.txt является важным шагом для предотвращения индексации нежелательных страниц на вашем сайте и управления трафиком.

После внесения необходимых изменений в файл robots.txt сохраните его и загрузите на сервер с помощью FileZilla или другого FTP-клиента.

После этого проверьте правильность настройки запрета индексации страницы. Для этого воспользуйтесь инструментами проверки индексации, доступными в поисковых системах, таких как Яндекс. Введите адрес вашей страницы и убедитесь, что она больше не индексируется.

Учтите, что в зависимости от поисковых систем и способов индексации, эти указания могут быть интерпретированы по-разному. Поэтому рекомендуется регулярно проверять индексацию ваших страниц и корректировать файл robots.txt при необходимости.

Теперь вы знаете, как настроить запрет индексации страницы вашего сайта с помощью файла robots.txt. Используйте эту инструкцию для защиты вашего контента от дублирования и контроля индексации поисковыми системами.